Disclosure /資訊披露

使用者對 AI 技術的信任是關鍵。明確告知使用者與 AI 的互動和內容,能有效建立信任關係。當使用者知情且自願參與時,更容易接受 AI。

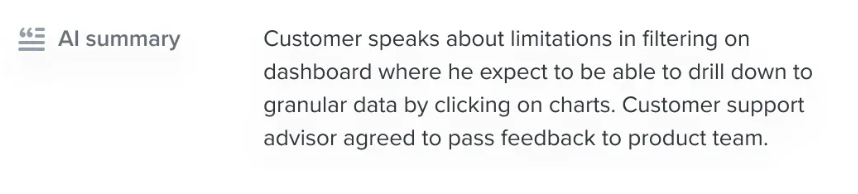

披露模式透過標記 AI 生成的內容,幫助使用者區分人工和 AI 內容,提升透明度並讓使用者更好地掌控互動體驗。

應用場景與建議

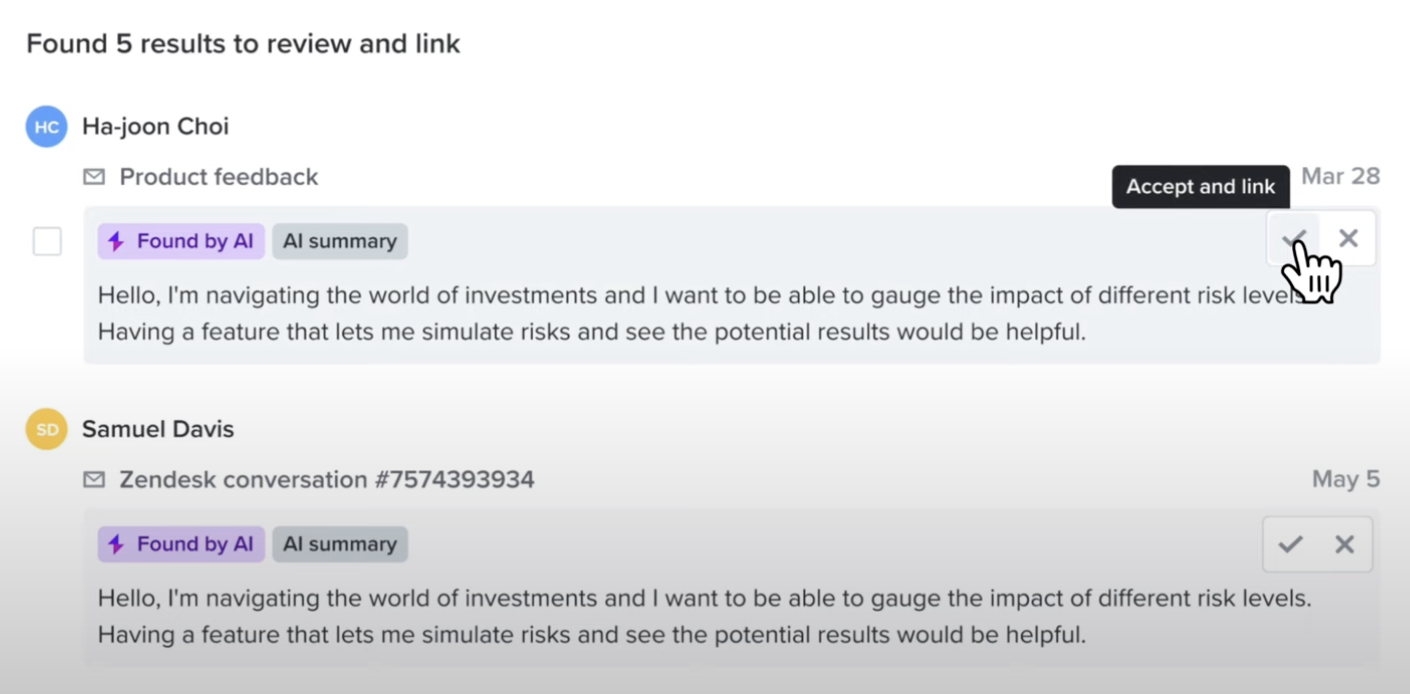

完全基於 AI 的產品:如 ChatGPT 和 Perplexity,這類產品圍繞 AI 功能設計,使用者已經預期會與 AI 互動。改進建議:區分使用者上傳或引用的內容與 AI 生成內容,例如透過標註或顏色區分。

人機混合產品:

對於同時包含 AI 和人工生成內容的產品,需要明確標記 AI 生成部分。

優勢:避免使用者將 AI 生成的內容誤認為是人工創作,並賦予使用者管理內容的自主權。

AI 代理場景

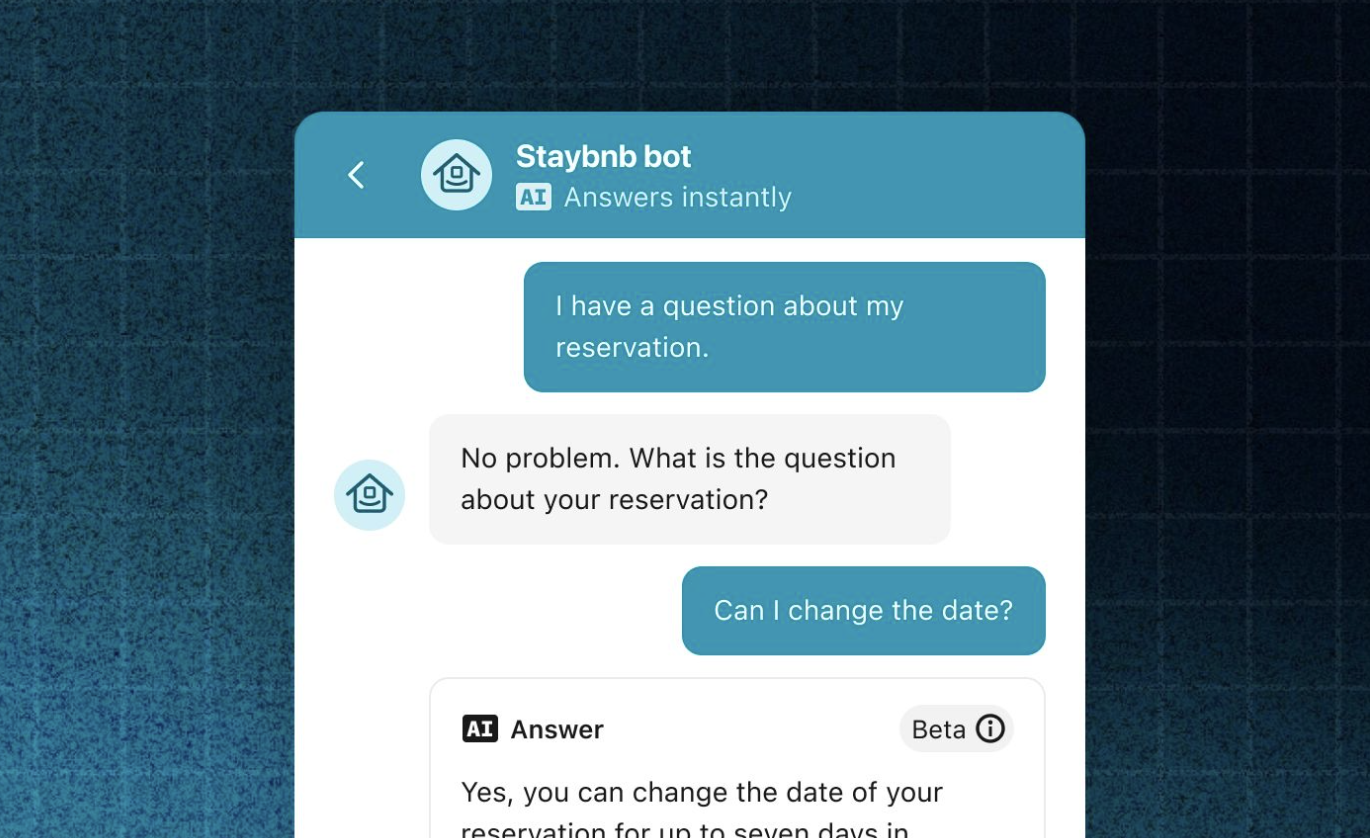

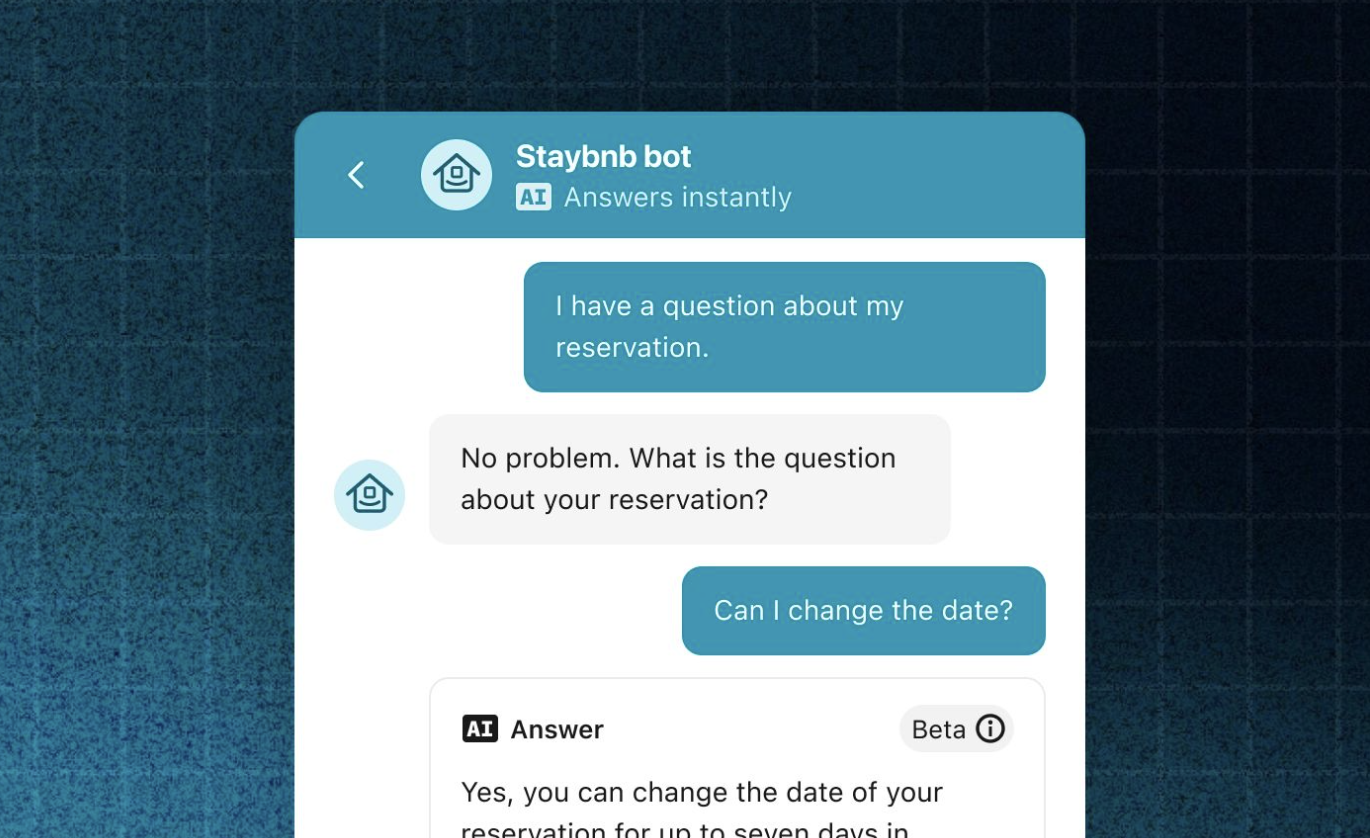

在聊天或服務互動中,標記 AI 響應,例如明確提示使用者何時從 AI 切換到人工客服。

重要性:使用者對與人類互動的期待不同,混淆可能損害品牌聲譽。

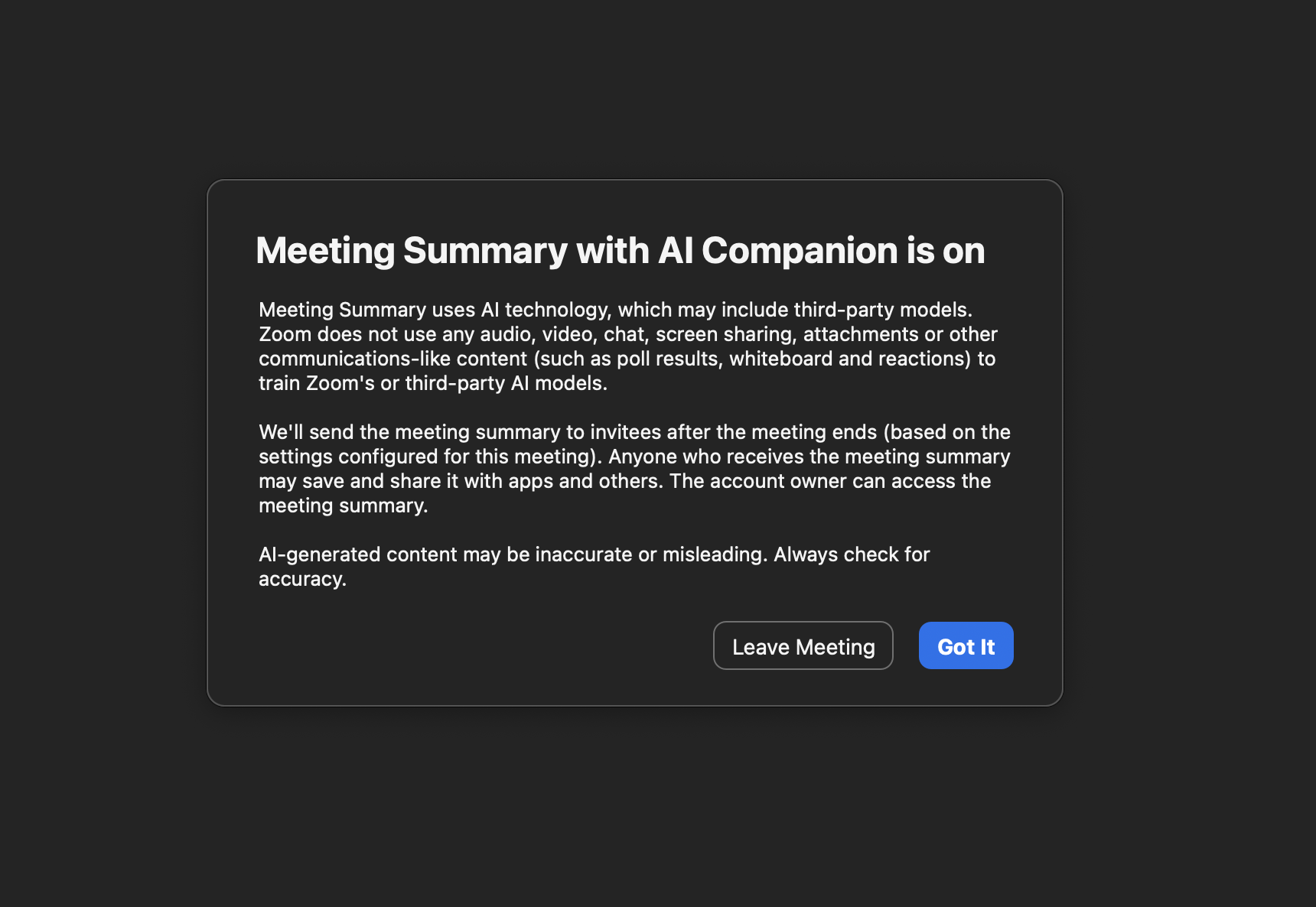

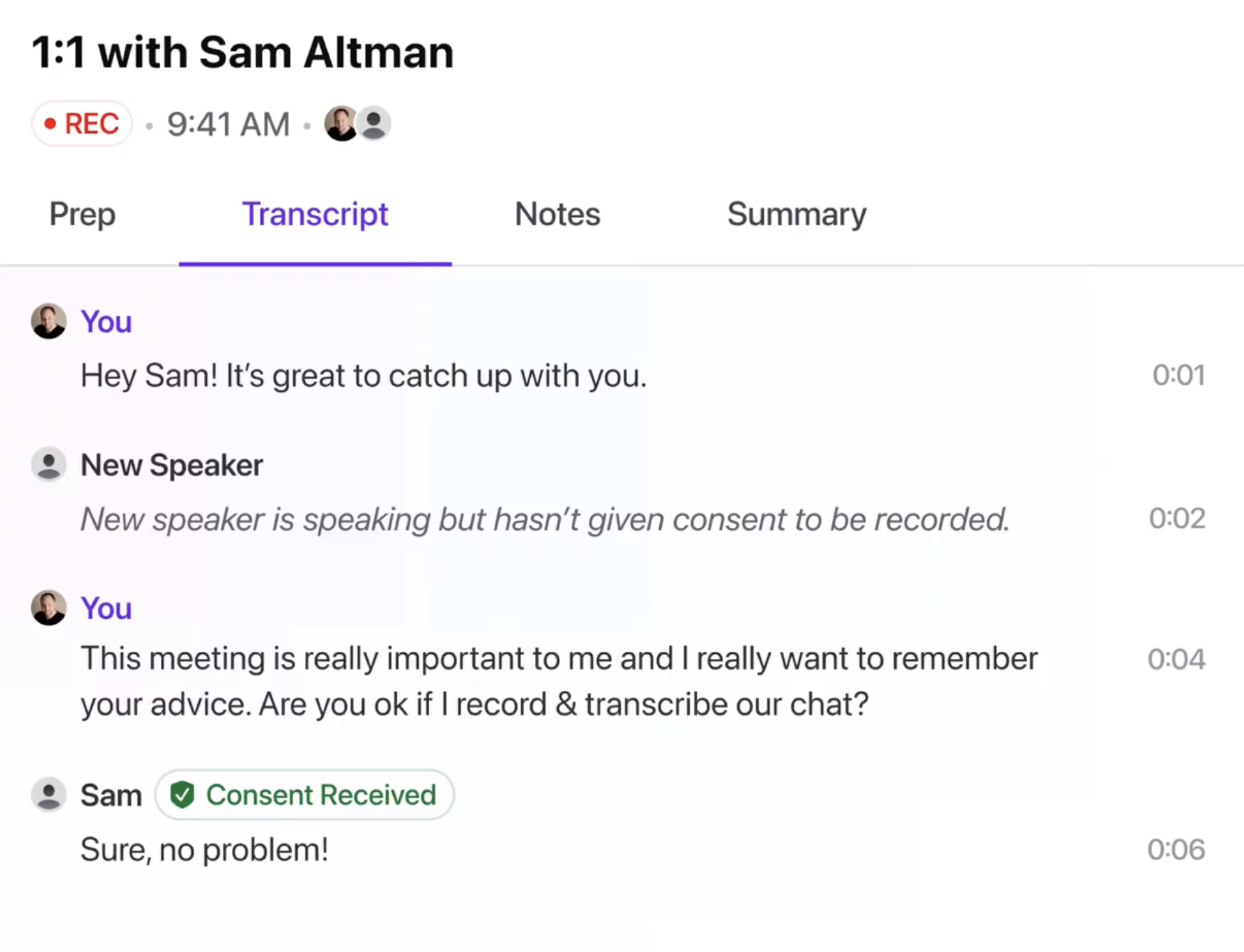

資料收集與同意

如果 AI 產品可能收集使用者資料,應在互動開始時清晰告知使用者,並提供退出選項。

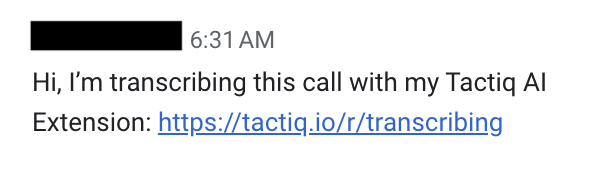

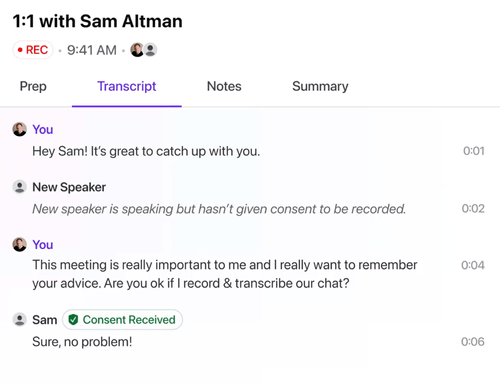

如 Limitless.ai,在記錄對話前要求對方明確同意。

不同方法

清晰標記

示例:Intercom 的 Fin 在每條 AI 生成的訊息上新增“AI”標籤,且當切換至人工客服時,標籤持續存在,便於使用者追溯對話過程。

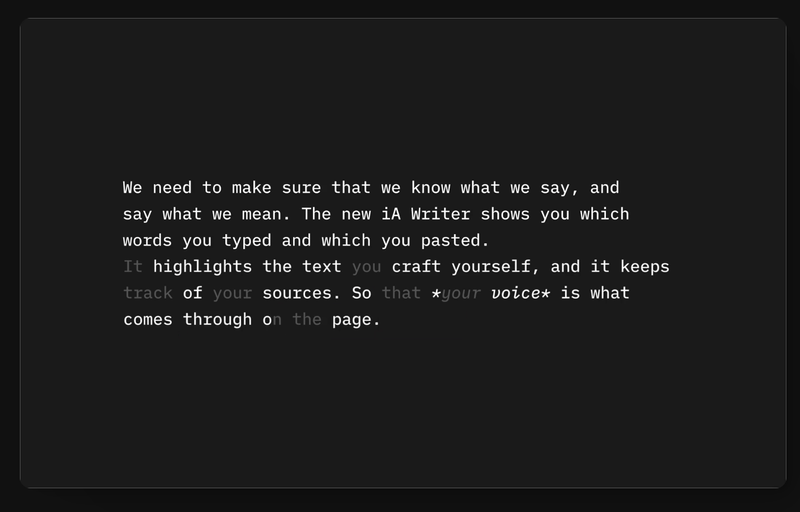

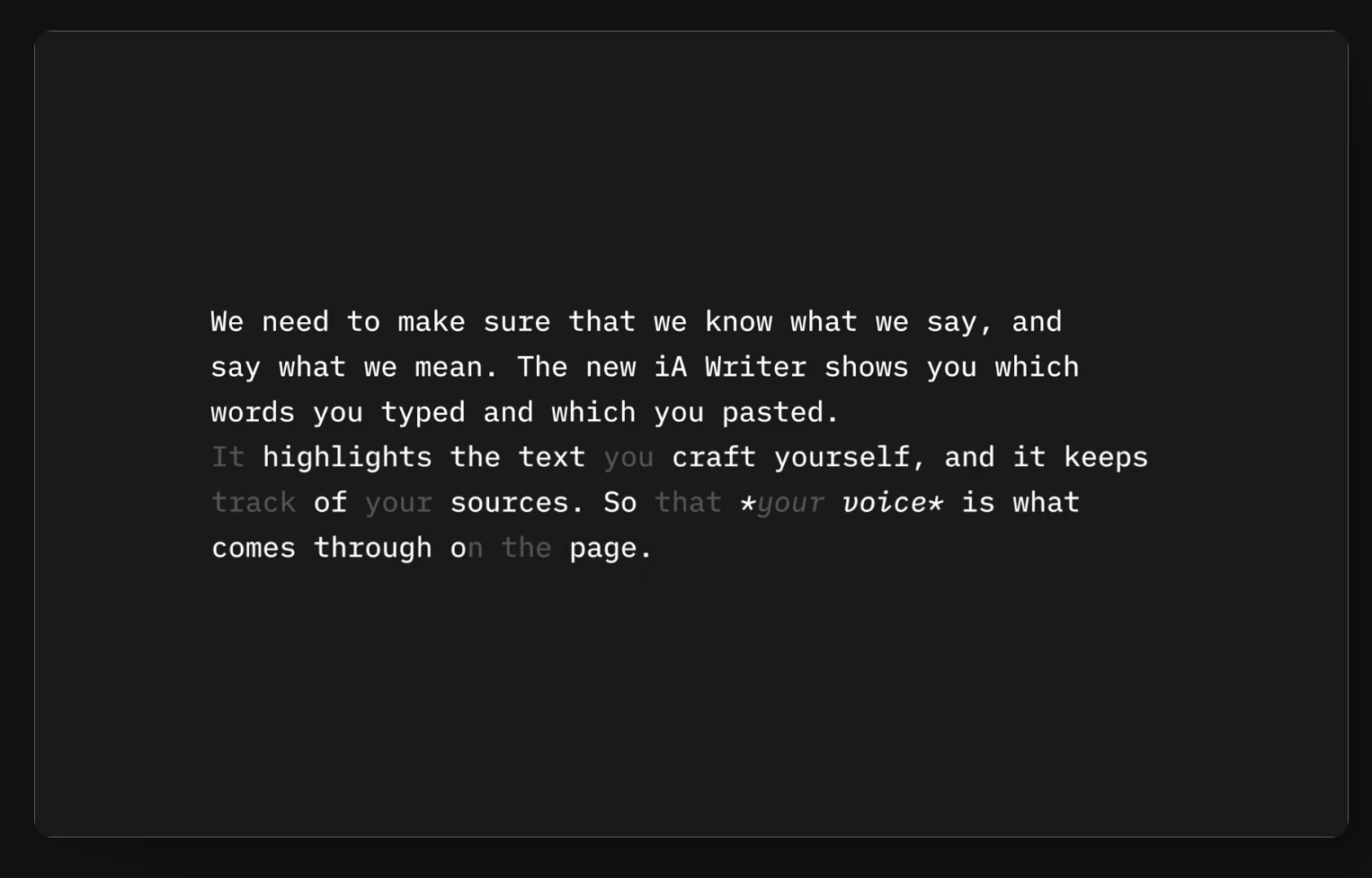

顏色區分

示例:IA Writer 使用灰色標記 AI 生成文字,使用者修改後的內容則恢復為標準高對比度顏色。

同意機制

示例:Limitless.ai 的裝置在記錄其他人的語音之前,要求對方同意;否則,僅記錄使用者自身語音。

反面案例:不透明操作

- 像 Meta 的工具套件未提供退出選項,強制使用 AI 功能。雖然這可能增加訓練資料的質量,但顯著降低了公眾對平臺的信任。

- 企業在短期內可能受益於這種策略,但長期來看,這種做法可能損害品牌聲譽。

功能細節與變體

- 基本披露:包括說明 AI 存在的簡短文字,可選新增圖示或符號。在人機切換時明確提示,並讓使用者可追溯之前的互動記錄。

- 使用者選擇權:允許使用者退出與 AI 的互動,例如要求 AI 在開始時宣佈其存在,或在記錄前徵求同意。

優勢

- 透明性作為功能亮點:擁有創新透明性方法的公司如 Intercom 和 Limitless.ai,往往在市場中脫穎而出。

- 使用者自治權與商業成功並非對立,透明性和隱私保護甚至可以成為品牌的核心差異點。

- 信任即貨幣:投資於信任構建不僅能獲得短期使用者支援,也有助於應對未來可能變化的政策和法律環境。

潛在風險

- 使用者體驗與業務目標衝突:有些公司可能優先考慮商業利益,而忽略使用者體驗。這會損害使用者權益,從而影響長遠發展。建議:設計師應努力平衡兩者,保護使用者體驗的同時達到業務目標。

- 使用者不滿:如果使用者發現他們與 AI 互動卻未被明確告知,可能對平臺產生反感。

- 改進建議:清晰告知 AI 存在.在所有涉及 AI 的互動或內容中明確披露,並儘可能簡化資訊,以便使用者快速理解。

- 提升互動透明度:提供明確的標記(如標籤或顏色)以區分 AI 與人工生成內容,增強使用者辨識度。

- 賦予使用者控制權:提供選擇權,例如允許使用者退出 AI 功能或控制資料收集行為。

- 利用透明性作為品牌優勢:將隱私保護和透明性作為產品的一部分,並用直觀設計體現出來,吸引更廣泛的使用者群體。